Notice

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 |

Tags

- 알고리즘

- deep learning

- 네트워크

- 밑바닥부터 시작하는 딥러닝

- 머신러닝

- Django

- 프로토콜

- 코딩테스트

- 네트워크 자격증

- 파이썬

- dns

- 딥러닝

- FTP

- 네트워크 관리사

- IPV4

- Windows Server

- 패스트캠퍼스

- 기본 정렬

- 자격증

- Algorithm

- 네트워크 관리사 2급

- network

- 자료구조

- 서브넷마스크

- Python

- 실기

- Dynamic Programming

- Machine learning

- ICQA

- Protocol

Archives

- Today

- Total

쳉지로그

[밑바닥부터 시작하는 딥러닝] Chapter 4. 신경망 학습(2) 본문

4.3 수치 미분

4.3.1 미분

- 미분: 한순간의 변화량을 표시

(참고)

수치미분: 아주 작은 차분으로 미분하느 것

해석적 미분: 수식을 전개해 미분하는 것. 오차를 포함하지 않는 진정한 미분 값을 구해줌

함수를 미분하는 계산 구현

4.3.2 수치 미분의 예

4.3.3 편미분

- 편미분(Partial Derivative): 변수가 여럿인 함수에 대한 미분 변수가 여럿인 함수에 대한 미분

편미분 예시

- 편미분은 변수가 하나인 미분과 마찬가지로 특정 장소의 기울기를 구함

- 단, 여러 변수 중 목표 변수 하나에 초점을 맞추고 다른 변수는 값을 고정

4.4 기울기

- 기울기(gradient): 모든 변수의 편미분을 벡터로 정리한 것

- 기울기가 가리키는 쪽은 각 장소에서 함수의 출력 값을 가장 크게 줄이는 방향

기울기 구현 코드

4.4.1 경사법(경사 하강법)

- 기계학습과 신경망에서는 학습 단계에서 최적(손실 함수가 최솟값이 될 때의 값)의 매개변수를 찾아야 함

- 경사법(Gradient descent): 기울어진 방향으로 일정 거리만큼 이동하는 것을 반복하여 최솟값을 찾아가는 방법. 즉, 기울기를 잘 이용해 함수의 최솟값(또는 가능한 한 작은 값)을 찾으려는 것

- 학습률(learning rate) : 𝜂(eta, 에타). 갱신하는 양

- 한 번의 학습으로 얼마만큼 학습해야 할지, 즉 매개변수를 얼마나 갱신하느냐를 정하는 것

- 학습률 값은 0.01이나 0.001 등 미리 특정 값으로 정해두어야 함

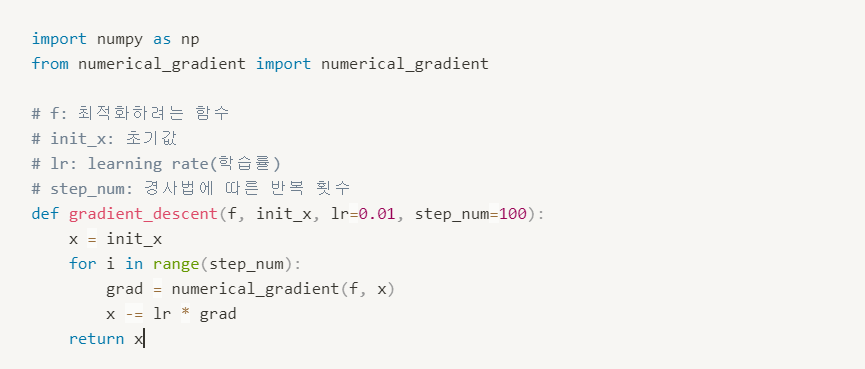

경사 하강법 구현 코드

(참고) 하이퍼파라미터(hyper parameter, 초매개변수) :

- 학습률과 같이 사람이 직접 설정해야 하는 매개변수

- 가중치와 편향같은 신경망의 매개변수와는 성질이 다름

- 신경망의 가중치 매개변수: 훈련 데이터와 학습 알고리즘에 의해서 자동으로 획득됨

4.4.2 신경망에서의 기울기

- 신경망에서도 가중치 매개변수에 대한 손실 함수의 기울기를 구해야 함

예시) 형상이 2x3, 가중치가 𝑾, 손실 함수가 𝐿인 신경망 , 기울기 𝜕𝐿/𝜕W

'머신러닝 > 밑바닥부터 시작하는 딥러닝' 카테고리의 다른 글

| [밑바닥부터 시작하는 딥러닝] Chapter 7. 합성곱 신경망(CNN) (1) (0) | 2021.05.09 |

|---|---|

| [밑바닥부터 시작하는 딥러닝] Chapter 5. 오차역전파법 (0) | 2021.04.28 |

| [밑바닥부터 시작하는 딥러닝] Chapter 4. 신경망 학습(1) (0) | 2021.04.21 |

| [밑바닥부터 시작하는 딥러닝] Chapter 3. 신경망 (0) | 2021.04.14 |

| [밑바닥부터 시작하는 딥러닝] Chapter 2. 퍼셉트론 (0) | 2021.04.14 |

Comments